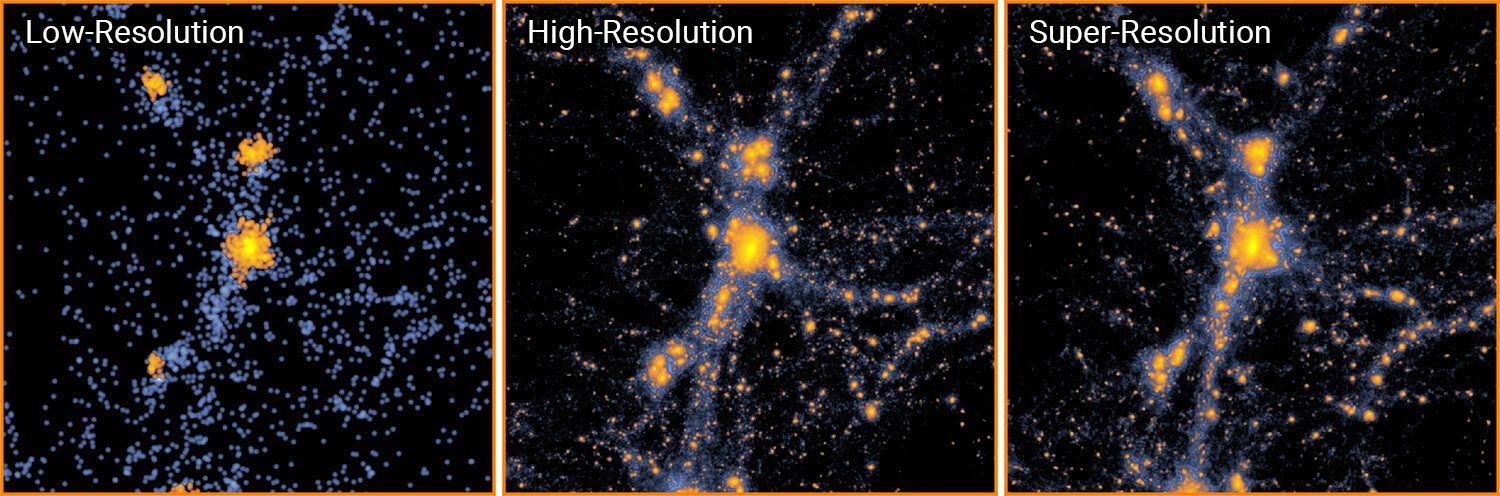

La simulación más a la izquierda se ejecutó a baja resolución. Usando el aprendizaje automático, los científicos escalaron el modelo de baja resolución para crear una simulación de alta resolución (derecha). Esta simulación cubre los mismos detalles que un modelo convencional de alta resolución (centro), pero requiere significativamente menos recursos informáticos. Fuente: Y. Li et al./Proceedings of the National Academy of Sciences 2021

El universo evoluciona a lo largo de miles de millones de años, pero los científicos han descubierto una forma de crear un universo simulado complejo en menos de un día. Técnica publicada esta semana Materiales de la Academia Nacional de Cienciascombina el aprendizaje automático, la computación de alto rendimiento y la astrofísica para marcar el comienzo de una nueva era de simulaciones cosmológicas de alta resolución.

Las simulaciones cosmológicas son una parte esencial para descubrir los muchos secretos del universo, incluida la materia oscura y la energía oscura. Pero hasta ahora, los científicos se han enfrentado al misterio común de que no han podido comprenderlo todo: las simulaciones podrían enfocarse en un área pequeña a alta resolución o cubrir un gran volumen del universo a baja resolución.

Los profesores de física de la Universidad Carnegie Mellon Tiziana Di Matteo y Rupert Croft, miembro del Instituto Flatiron Yin Li, Dr. Carnegie Mellon. El candidato Yueying Ni, profesor de física y astronomía en la Universidad de California en Riverside Simeon Bird y Yu Feng de la Universidad de California, Berkeley superaron este problema al enseñar un algoritmo de aprendizaje automático basado en redes neuronales para mejorar la simulación de baja resolución a súper resolución. .

“Las simulaciones cosmológicas deben involucrar una gran cantidad de investigación cosmológica y, al mismo tiempo, requieren alta resolución para resolver la física de la formación de galaxias a pequeña escala, lo que plantearía difíciles desafíos computacionales. Nuestra técnica se puede utilizar como una herramienta poderosa y prometedora para alinear los dos. requisitos al modelar la física de la formación de galaxias a pequeña escala en grandes volúmenes cosmológicos ”, dijo Ni, quien entrenó el modelo, construyó una tubería de prueba y validación, analizó los datos y realizó una visualización basada en datos.

El código entrenado puede aceptar modelos a escala completa de baja resolución y generar simulaciones de súper resolución que contienen hasta 512 veces más partículas. Para un área de aproximadamente 500 millones de años luz de diámetro y 134 millones de partículas, los métodos existentes requerirían 560 horas para realizar una simulación de alta resolución utilizando un solo núcleo de procesamiento. Gracias al nuevo enfoque, los científicos solo necesitan 36 minutos.

Los resultados fueron aún más dramáticos cuando se agregaron más partículas a la simulación. Para un universo 1,000 veces más grande con 134 mil millones de partículas, el nuevo método de los científicos tomó 16 horas en una sola GPU. Utilizando los métodos actuales, una simulación de este tamaño y resolución llevaría meses a una supercomputadora dedicada.

Reducir el tiempo necesario para ejecutar simulaciones cosmológicas “tiene el potencial de hacer avances significativos en cosmología numérica y astrofísica”, dijo Di Matteo. “Las simulaciones cosmológicas siguen la historia y el destino del universo hasta la formación de todas las galaxias y sus agujeros negros”.

Los científicos utilizan simulaciones cosmológicas para predecir cómo se verá el universo en diferentes escenarios, como si la energía oscura que separa el universo cambia con el tiempo. Las observaciones telescópicas luego confirman si las predicciones de la simulación son ciertas.

“En nuestras simulaciones anteriores, hemos demostrado que podemos simular el universo para descubrir física nueva e interesante, pero solo en baja o baja resolución”, dijo Croft. “Gracias al uso del aprendizaje automático, la tecnología puede seguir el ritmo de nuestras ideas”.

Di Matteo, Croft y Ni son parte del Instituto de Planificación de la Fundación Nacional de Ciencias de Carnegie Mellon (NSF) para la Inteligencia Artificial en Física, que apoyó este trabajo, y son miembros del Centro McWilliams de Cosmología Carnegie Mellon.

“El universo es el conjunto de datos más grande disponible: la inteligencia artificial es la clave para comprender el universo y descubrir nueva física”, dijo Scott Dodelson, profesor y director de física en la Universidad Carnegie Mellon y director del Instituto de Planificación NSF. “Esta investigación muestra cómo el Instituto de Planificación de Inteligencia Artificial de NSF hará avanzar la física a través de la inteligencia artificial, el aprendizaje automático, las estadísticas y la ciencia de datos”.

“Está claro que la IA tiene una fuerte influencia en muchos campos de la ciencia, incluida la física y la astronomía”, dijo James Shank, director del programa del Departamento de Física de la NSF. “Nuestro programa del Instituto de Planificación de IA trabaja para que la IA acelere el descubrimiento. Este nuevo resultado es un buen ejemplo de cómo la inteligencia artificial está cambiando la cosmología “.

Para crear un nuevo método, Ni y Li utilizaron estos campos para crear código que usa redes neuronales para predecir cómo la gravedad mueve la materia oscura a lo largo del tiempo. Las redes recopilan datos de entrenamiento, realizan cálculos y comparan los resultados con los resultados esperados. Con más formación, las redes se adaptan y se vuelven más precisas.

El enfoque específico utilizado por los científicos, llamado red generativa de oponentes, enfrenta a dos redes neuronales entre sí. Una red simula el universo a baja resolución y lo usa para generar modelos de alta resolución. La segunda red trata de distinguir estas simulaciones de las realizadas por métodos convencionales. Con el tiempo, ambas redes neuronales mejoran cada vez más hasta que finalmente el generador de simulación gana y crea simulaciones rápidas que se parecen a las lentas convencionales.

“No pudimos conseguir que trabajara durante dos años”, dijo Li, “y de repente empezó a funcionar. Obtuvimos hermosos resultados que coincidieron con nuestras expectativas. Incluso hicimos algunas pruebas a ciegas nosotros mismos, y la mayoría de nosotros no podíamos decir cuál era “real” y cuál era “falso”. “

A pesar de aprender solo en pequeñas áreas del espacio, las redes neuronales duplicaron con precisión las estructuras a gran escala que solo aparecen en grandes simulaciones.

Sin embargo, las simulaciones no capturaron todo. Al centrarse en la materia oscura y la gravedad, se omitieron los fenómenos de menor escala como la formación de estrellas, las supernovas y los efectos de los agujeros negros. Los científicos planean extender sus métodos a las fuerzas responsables de tales fenómenos y ejecutar sus redes neuronales “sobre la marcha” junto con simulaciones convencionales para aumentar la precisión.

Proporcionado por la Universidad Carnegie Mellon