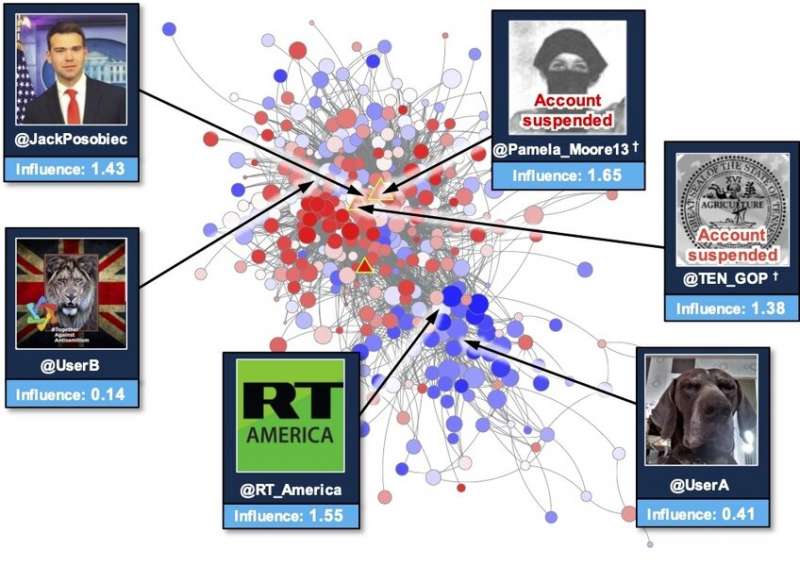

El equipo de investigación de Reconocimiento de Operaciones de Influencia en el Laboratorio Lincoln trazó un mapa de una red de propaganda extranjera en Twitter que estuvo activa durante las elecciones presidenciales francesas de 2017. Los círculos rojos más grandes representan facturas operativas influyentes y posiblemente influyentes. Fuente: Instituto de Tecnología de Massachusetts

Las campañas de desinformación no son nuevas; pensemos en la propaganda de guerra utilizada para influir en el público sobre el enemigo. Sin embargo, lo nuevo es el uso de Internet y las redes sociales para difundir estas campañas. La difusión de desinformación a través de las redes sociales puede cambiar las elecciones, fortalecer las teorías de la conspiración y generar discordia.

Steven Smith, miembro del Grupo de Algoritmos y Arquitecturas de Software de Inteligencia Artificial del Laboratorio Lincoln del MIT, es parte del equipo que se propuso comprender mejor estas campañas mediante el lanzamiento del programa Reconnaissance of Influence Operations (RIO). Su objetivo era crear un sistema que se detectara automáticamente desinformación narrativas, así como individuos que difunden las narrativas dentro de la comunidad medios de comunicación redes. A principios de este año, el equipo publicó un artículo sobre su trabajo en Materiales de la Academia Nacional de Ciencias y el otoño pasado recibieron el premio R&D 100.

El proyecto comenzó en 2014, cuando Smith y sus colegas investigaron cómo los grupos maliciosos podrían usar las redes sociales. Notaron una actividad creciente e inusual en los datos de las redes sociales de cuentas que parecían estar impulsando narrativas prorrusas.

“Nos rascamos la cabeza”, dice Smith sobre los datos. Entonces, el equipo solicitó financiamiento interno a través de la oficina de tecnología del laboratorio y lanzó el programa para investigar si se utilizarían técnicas similares en las elecciones francesas de 2017.

En los 30 días previos a las elecciones, el equipo de RIO recopiló datos de las redes sociales en tiempo real para buscar y analizar la propagación de la desinformación. En total, recopilaron 28 millones de publicaciones en Twitter de 1 millón de cuentas. Luego, utilizando el sistema RIO, pudieron detectar cuentas de desinformación con una precisión del 96 por ciento.

RIO es único en el sentido de que combina múltiples técnicas analíticas para crear una imagen completa de dónde y cómo se difunden las narrativas de desinformación.

“Si está tratando de responder a la pregunta de quién influye en una red social, tradicionalmente la gente observa cómo cuenta la actividad”, dice Edward Kao, otro miembro del equipo de investigación. En Twitter, por ejemplo, los analistas considerarían la cantidad de tweets y retweets. “Encontramos que esto es insuficiente en muchos casos. En realidad, no le informa sobre el impacto de sus cuentas en la red social “.

Como parte del doctorado de Kao. trabajo en el laboratorio de Lincoln Scholars, programa de becas, desarrollado enfoque estadístico—Actualmente utilizado en RIO – para ayudar a determinar no solo si una cuenta de redes sociales está difundiendo desinformación, sino también hasta qué punto hace que toda la red altere y refuerce el mensaje.

Erika Mackin, otro miembro del equipo de investigación, también aplicó un nuevo enfoque de aprendizaje automático que ayuda a RIO a clasificar estas cuentas mediante el análisis de datos relacionados con comportamientos como cuenta interactúa con medios extranjeros y qué idiomas usa. Este enfoque permite a RIO detectar cuentas hostiles que están activas en varias campañas, desde las elecciones presidenciales francesas de 2017 hasta la difusión de información errónea sobre COVID-19.

Otro aspecto único de RIO es que puede detectar y cuantificar el impacto de las cuentas tanto de bots como de humanos, mientras que la mayoría de los sistemas automatizados en uso hoy en día solo detectan bots. RIO también puede ayudar a las personas que utilizan el sistema a pronosticar cómo diferentes contramedidas podrían detener la propagación de una campaña de desinformación específica.

El equipo anticipa que RIO será utilizado tanto por el gobierno como por la industria, y más allá medios de comunicación social y en el ámbito de los medios tradicionales como los periódicos y la televisión. Actualmente están trabajando con el estudiante de West Point Joseph Schlessinger, quien también es Estudiante de doctorado en el MIT y el ejército en el Laboratorio Lincoln para comprender cómo se difundieron las narrativas en los medios europeos. También se está trabajando en un nuevo programa de seguimiento para profundizar en los aspectos cognitivos de las operaciones de influencia y cómo la desinformación afecta las actitudes y comportamientos individuales.

“Defenderse de la desinformación no es solo una cuestión de seguridad nacional, sino también de proteger la democracia”, dice Kao.

Steven T. Smith et al., Detección automática de actores influyentes en redes de desinformación, Materiales de la Academia Nacional de Ciencias (2021). DOI: 10.1073 / Lun.2011216118

Entregado por

Instituto de Tecnología de Massachusetts

Esta historia se volvió a publicar por cortesía de MIT News (web.mit.edu/newsoffice/), un sitio popular de noticias sobre investigación, innovación y enseñanza del MIT.